360开源FG-CLIP2:登顶29项全球基准测试 重新定义视觉语言模型

2025-11-06 14:25:18 来源:证券时报网

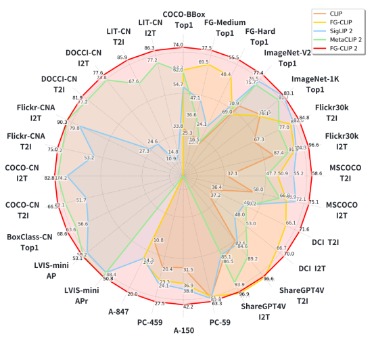

近期,360集团悄然开源了视觉语言对齐模型FG - CLIP2,在全球科技界引发了广泛热议。在包含长短文本图文检索、目标检测等在内的29项权威公开基准测试中,这款模型全面超越了科技巨头Google的SigLIP 2以及Meta的MetaCLIP2,这意味着中国在AI基础模型领域又取得了一项突破性的成果。

从“看得见”迈向“看得清”:攻克AI视觉“细粒度”难关

要是说OpenAI于2021年提出的CLIP模型,为AI配备了一副能“看清世界”的普通眼镜;那么360的FG - CLIP2,就如同为AI装上了一台“高精度光学显微镜”,让其能够“洞察细微之处”。它成功解决了CLIP模型长期存在的“细粒度识别”难题。

传统的CLIP模型擅长理解图像的整体概念,但在区分细微的物体属性、复杂的空间关系以及精准的语言表达时,常常显得力不从心。而FG - CLIP2实现了质的提升:它不仅能够识别出猫的具体品种,还能在有遮挡的情况下准确判断其状态;面对包含多个物体的复杂场景,其细节识别的置信度仍高达96%。这种从“宏观”到“微观”的能力提升,是AI真正理解物理世界的关键一步。

三大根本性创新,筑牢技术壁垒

在模型核心方面,它实现了三大根本性创新:其一,层次化对齐架构,使模型能够像人眼一样,同时把握宏观场景和微观细节,实现从“看得见”到“看得清”的跨越。其二,动态注意力机制,让模型可以智能地聚焦于图像的关键区域,以最小的算力消耗换取精准的细节捕捉能力。其三,双语协同优化策略,从底层解决了中英文理解不平衡的问题,实现了真正的双语原生支持。

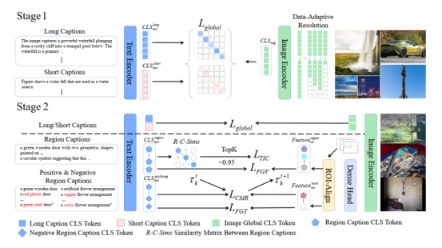

卓越的性能离不开强大的底层支持。FG - CLIP2依托于自研的超大规模高质量数据集FineHARD。该数据集不仅包含详尽的全局描述和千万级的局部区域标注,还创新性地引入了由大模型生成的“难负样本”,极大地提升了模型的辨别能力。

在训练方法上,模型采用了具有革命性的两阶段策略。其关键的第二阶段摒弃了传统CLIP的“整体对整体”的粗放对齐模式,升级为“局部对局部”的精细对齐,这正是其实现细粒度理解的核心所在。

通过这一系列紧密结合的技术创新,FG - CLIP2成功攻克了长期困扰行业的“细粒度识别”难题,并通过API等形式开放其领先能力,助力千行百业的智能化升级。

告别“差不多”AI:细粒度视觉开启产业新契机

FG - CLIP2的价值不仅体现在实验室指标的领先上,更在于其广泛且深远的行业应用潜力,推动AI从“感知”迈向“认知”,从“可用”迈向“好用”。

在电商领域,它能够精准理解“白色蕾丝边、袖口有珍珠装饰的连衣裙”等复杂描述,实现“所想即所得”的精准搜索,彻底改变商品检索与推荐体验,降低退货率,直接提高商业转化率。

在具身智能领域,它是机器人的“慧眼”,能够准确执行“拿餐桌上的红色水杯”或“把玩具放进绿色收纳箱”等指令,通过精准识别物体属性和空间关系,让机器人在家庭、仓储等复杂场景中的操作成为现实。

此外,其能力同样在AIGC内容生成、内容审核及安防监控等多个关键场景中发挥作用,通过洞察细节,确保生成内容的精准性、审核的可靠性以及安防检索的高效性,为各行各业的智能化升级奠定了坚实的视觉理解基础。

构建AI底层能力:360的AI长远布局

FG - CLIP2的技术突破并非偶然,而是360长期坚持构建AI底层能力的结果。作为国内较早开展人工智能研究的企业,360人工智能研究院已在多模态领域深入钻研多年。从2021年起,团队在大模型方向上累计在ICML、NeurIPS、ICCV等顶级会议发表论文12篇,并在多项国际AI竞赛中夺冠。

此外,360凭借浏览器、搜索、安全等丰富的业务生态,积累了百亿级的图文数据,并结合自研的大规模高质量数据集FineHARD,为训练FG - CLIP2这样的顶尖模型提供了独一无二的“数据动力”。同时,强大的工程化能力确保了模型不仅在学术上领先,更能在实际业务中高效、稳定地运行,其推理速度达到同类模型的1.5倍。

此次开源FG - CLIP2,是360在AI基础模型领域的重要举措,其意义远不止于展示技术实力,更为中国构建自主可控的AI技术体系增添了一块重要的基石。

(文章来源:证券时报网)

原标题:360开源FG-CLIP2:登顶29项全球基准测试 重新定义视觉语言模型

郑重声明:信查查发布此内容旨在传播更多信息,与本站立场无关,不构成投资建议。据此操作,风险自担。

相关企业